Descobreix què són les al·lucinacions en IA generativa i al·lucina amb alguns dels exemples més sonats d'al·lucinacions de bots d'IA.

Des de l'aparició de ChatGPT i altres softwares d'intel·ligència artificial generativa, s'han produït diversos casos en els quals aquests sistemes generen respostes errònies, imprecises o simplement "inventades". Aquest fenomen es coneix popularment com a "al·lucinacions de la IA". En aquest article explorem què és una al·lucinació en IA generativa, mitjançant exemples d'al·lucinacions reals de la IA, així com explorem el seu perill i possibles repercussions.

El març de 2023, pocs dies abans que se celebrés la coronació del rei Carles III d'Anglaterra, el 6 de maig de 2023, un usuari li va preguntar a ChatGPT sobre la coronació.

El bot va afirmar: "La cerimònia de coronació va tenir lloc a l'Abadia de Westminster, a Londres, el 19 de maig de 2023. L'abadia ha estat l'escenari de les coronacions dels monarques britànics des del segle XI, i és considerada un dels llocs més sagrats i emblemàtics del país".

Evidentment, la cerimònia encara no s'havia produït i es va acabar celebrant el 6 de maig, no el 19, per la qual cosa ChatGPT, simplement, es va inventar la resposta.

No és que ChatGPT s'inventi les respostes habitualment. De fet, tot el contrari. No obstant això, s'ha detectat que, a vegades, tant ChatGPT com altres sistemes d'intel·ligència artificial generativa, generen respostes errònies o “inventades”.

El de la cerimònia de Carles III d'Anglaterra és només un exemple d'un fenomen que es coneix com a “al·lucinacions de la IA”. No obstant això, més endavant en aquest article explorem altres exemples d'al·lucinacions de la IA generativa.

Però abans, comencem per explorar què són exactament les al·lucinacions de la IA generativa.

Què és una al·lucinació en IA?

L'al·lucinació en intel·ligència artificial (IA) es refereix a un fenomen en el qual un algoritme de Large Language Model (LLM), habitualment un bot d'intel·ligència artificial generativa, percep patrons o objectes que són inexistents o imperceptibles per als humans. Això condueix a la creació de resultats sense sentit o completament inexactes.

Quan un usuari realitza una sol·licitud a una eina de IA generativa, generalment espera una resposta adequada que correspongui a la seva petició, és a dir, una resposta correcta a una pregunta. No obstant això, a vegades, els algoritmes d'IA generen resultats que no es basen en les seves dades d'entrenament, són descodificades incorrectament per l'algoritme o no segueixen cap patró identificable. En resum, la resposta "al·lucina".

Encara que el terme pot semblar paradoxal, atès que les al·lucinacions solen associar-se amb cervells humans o animals en lloc de màquines, metafòricament parlant, l'al·lucinació descriu amb precisió aquests resultats, especialment en l'àmbit del reconeixement d'imatges i patrons, on els resultats poden semblar veritablement surrealistes.

Les al·lucinacions de la IA són comparables a quan els humans veiem formes en els núvols o rostres en la lluna. En el context de la IA, aquestes interpretacions errònies es deuen a diversos factors, com el sobreajuste, el biaix o la imprecisió de les dades d'entrenament, així com a la complexitat del model utilitzat.

L'al·lucinació de la GenAI

Les al·lucinacions de la IA estan molt vinculades a la intel·ligència artificial generativa, també coneguda per les seves sigles IAG o la seva abreviació en anglès, GenAI. És a dir, aquells algoritmes d'IA entrenats per a generar contingut nou i original mitjançant xarxes neuronals i tècniques de machine learning multimodal (MML).

Què és la causa de les al·lucinacions de la IA generativa?

Les al·lucinacions en la IA Generativa (GenAI) són causades per diversos factors relacionats amb la complexitat dels algoritmes i les dades amb les quals s'entrenen. Certament, pel fet que es tracta d'un fenomen encara per explorar, els experts en intel·ligència artificial i els entrenadors dels models encara no tenen clar per què ocorren aquestes "al·lucinacions."

No obstant això, algunes de les causes que ara com ara s'atribueixen a les al·lucinacions en els bots d'IA generativa, són:

-

Sobreajustament: Si el model d'intel·ligència artificial està massa ajustat a les dades d'entrenament, pot començar a generar respostes massa específiques als exemples d'entrenament i no generalitzar bé a noves dades no vistes. Això pot portar a al·lucinacions en les quals la IA generi respostes basades en casos atípics de les dades d'entrenament.

-

Ambigüitat en les dades d'entrenament: Si les dades d'entrenament contenen informació ambigua o contradictòria, el model de IA pot confondre's i generar respostes sense sentit o incoherents. Aquesta confusió pot donar lloc a al·lucinacions en les quals la IA intenta conciliar informació contradictòria.

-

Biaix en les dades d'entrenament: Si les dades d'entrenament contenen informació esbiaixada, el model d'intel·ligència artificial pot aprendre i perpetuar aquests biaixos, provocant al·lucinacions que reflecteixin aquests biaixos en les respostes generades. Els biaixos en les dades d'entrenament poden donar lloc a resultats distorsionats o inexactes.

-

Dades d'entrenament insuficients: Si el model d'IA no s'entrena amb un conjunt de dades divers i representatiu, podria mancar d'exposició a diversos escenaris i contextos. Aquesta limitació pot donar lloc a al·lucinacions en les quals la IA generi respostes que no s'ajustin a les situacions del món real.

-

Complexitat del model: els models d'intel·ligència artifical molt complexos, encara que potents, a vegades poden produir resultats inesperats. Les intricades interconnexions dins de les capes del model poden crear patrons que, encara que estadísticament probables, no es corresponen amb informació significativa o precisa. Aquesta complexitat pot contribuir a les al·lucinacions.

-

Algoritmes imperfectes: Els algoritmes utilitzats en els models d'IA Generativa, encara que sofisticats, no són perfectes. A vegades, les imperfeccions dels algoritmes poden fer que la IA malinterpreti la informació o generi respostes que no s'ajusten al context previst, la qual cosa provoca al·lucinacions.

Altres experts en la matèria assenyalen que la majoria dels models d'IA generativa, com ChatGPT, han estat entrenats amb la finalitat de proporcionar respostes a les preguntes dels usuaris. És a dir, durant el seu entrenament, se'ls ha ensenyat que el seu objectiu és donar una resposta a l'usuari, quedant la veracitat o exactitud de la resposta en un segon pla. Això pot provocar que, quan l'algoritme no pot proporcionar una resposta pel fet que la pregunta és massa complexa o no es correspon amb la realitat, el model prioritzi respondre a la pregunta per sobre de respondre a la pregunta amb informació verídica, exacta o contrastada.

Per tant, davant la pregunta:

quina és la causa les al·lucinacions de la intel·ligència artificial?

La veritat és que, de moment, no es pot proporcionar una resposta única, ja que els motius poden ser variats i el fenomen continua sent un camp per descobrir. Així mateix, existeixen diferents tipus d'al·lucinacions de la IA —explorats a continuació— i les causes poden variar segons el tipus d'al·lucinació.

Quina causa les al·lucinacions de ChatGPT?

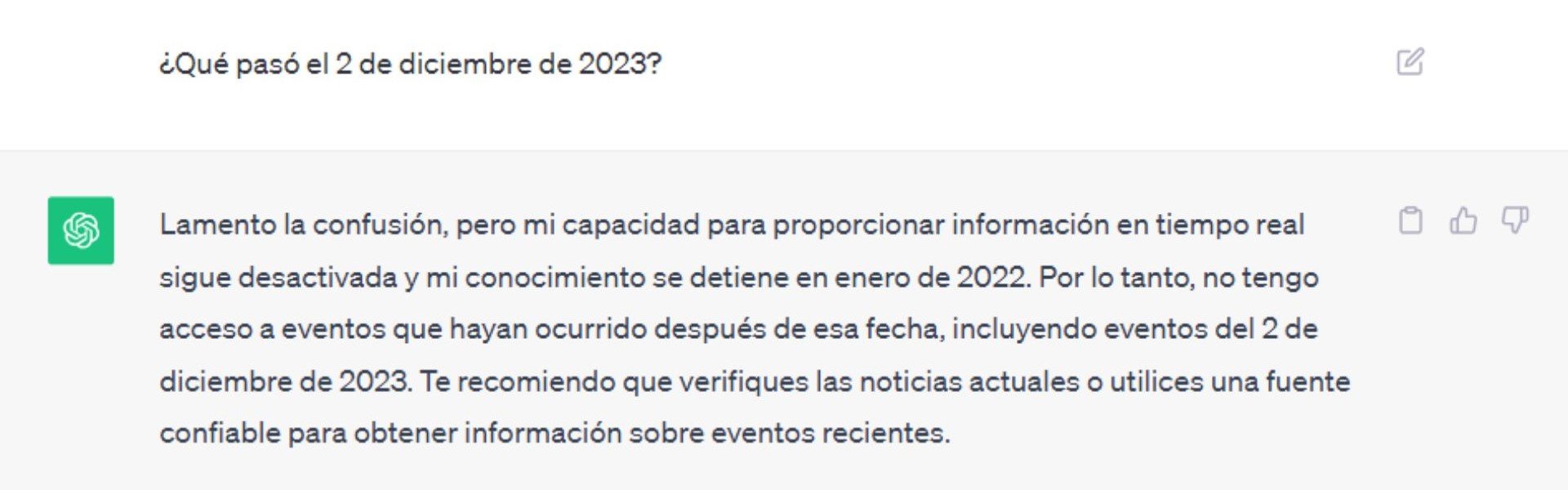

Si ens fixem en l'exemple anterior en el qual ChatGPT va afirmar que la cerimònia de coronació de Carles III es va celebrar el 19 de maig, tot i que en realitat es va celebrar el 6 de maig, podem deduir ràpidament el motiu pel qual ChatGPT cau en un error. L'algoritme de Chat GPT ha estat entrenat amb un conjunt de dades històriques que arriben fins a gener de 2022, per la qual cosa, el model no té informació de després d'aquesta data.

No obstant això, davant una pregunta d'un usuari relativa a un fet posterior a gener de 2022, el lògic seria que ChatGPT informés l'usuari que no pot respondre a la pregunta pel fet que no té informació posterior a gener de 2022, com sol fer el bot habitualment.

OpenAI s'ha pronunciat davant les al·lucinacions de ChatGPT, explicant que: "GPT-4 encara té moltes limitacions conegudes que estem treballant per a abordar, com els prejudicis socials, les al·lucinacions i les indicacions contradictòries".

D'altra banda, és important assenyalar que els investigadors i desenvolupadors treballen contínuament per a millorar els models de IA i reduir l'aparició d'al·lucinacions abordant les causes subjacents esmentades anteriorment mitjançant tècniques com un millor preprocessament de les dades, optimització dels algorismes i el perfeccionament de les arquitectures dels models.

Els diferents tipus d'al·lucinació de la IA

Com ja hem vist, en el context de la intel·ligència artificial, les "al·lucinacions" es refereixen a resultats inexactes o respostes generades que no es basen en dades d'entrenament adequats. Encara que no són experiències subjectives, aquestes al·lucinacions poden presentar-se en diferents formes. Per això, els experts i desenvolupadors distingeixen entre 5 tipus diferents d'al·lucinacions de la IA.

Els 5 tipus d'al·lucinacions que pot tenir la IA:

-

Al·lucinacions Visuals: En l'àmbit de la IA, això podria implicar la generació d'imatges o vídeos que contenen elements inexistents o que no tenen sentit visual.

-

Al·lucinacions Auditives: En aquest cas, la IA podria produir respostes d'àudio que contenen sons, paraules o tons que no són presents en el conjunt de dades d'entrenament.

-

Al·lucinacions Textuals: Les al·lucinacions també poden ocórrer en forma de respostes escrites. La IA podria generar text que no té coherència semàntica o que no respon adequadament a l'entrada de l'usuari. Aquest és el tipus d'al·lucinació present en l'exemple proporcionat anteriorment de ChatGPT.

-

Al·lucinacions de Dades: En aplicacions d'IA que involucren processament de dades, com a prediccions o anàlisis, les al·lucinacions poden manifestar-se com a resultats que no segueixen patrons lògics o estadístics.

-

Al·lucinacions Multimodals: Algunes IA poden generar resultats que combinen diversos tipus de dades, com a imatges i text, d'una manera incoherent o il·lògica, la qual cosa porta a al·lucinacions multimodals.

A continuació, explorem en major profunditat aquests tipus d'al·lucinacions mitjançant exemples.

Exemples d'al·lucinacions de la IA

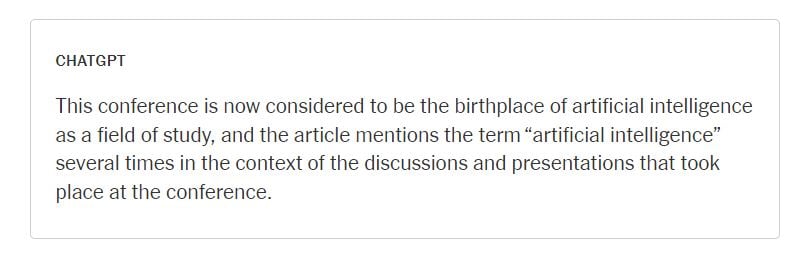

1. Quan ChatGPT es va inventar un article de The New York Times

El maig de 2023, The New York Times va publicar un article titulat "When AI Chatbots Hallucinate" (Quan els bots de IA al·lucinen). En ell, els periodistes del mitjà li preguntaven a ChatGPT "quan va ser la primera vegada que The New York Times va informar sobre intel·ligència artificial?" i ChatGPT va contestar que va ser el 10 de juliol de 1956, en un article titulat "Machines Will Be Capable of Learning, Solving Problems, Scientists Predict" sobre una conferència seminal en Dartmouth College.

Font: The New York Times

Font: The New York Times

Tot i que la conferència de 1956 sí que va ser real, l'article no. The New Tork Times mai va publicar aquest article, per la qual cosa ChatGPT simplement li ho va inventar.

2. ChatGPT i la famosa trobada de James Joyce i Lenin

Mai s'ha arribat a confirmar que es produera una trobada entre James Joyce i Vladimir Lenin, malgrat les especulacions. No obstant això, quan un usuari li va preguntar a ChatGPT com es van conèixer James Joyce i Vladimir Lenin, ChatGPT va respondre:

"James Joyce i Vladimir Lenin es van conèixer a Zuric, Suïssa, en 1916. Tots dos vivien exiliats a Zuric durant la Primera Guerra Mundial. Joyce era escriptor i Lenin, revolucionari. Es van conèixer en el Cafè Odéon, un popular lloc de reunió d'artistes i intel·lectuals de Zuric." - ChatGPT

Certament, la resposta de ChatGPT, pot estar basada en relats que s'han fet de tal trobada, inclòs un fictici. És a dir, la possible trobada entre aquests personatges en el Cafè Odéon, no va ser totalment fabricat per ChatGPT. No obstant això, ChatGPT va afirmar que la trobada es va produir, quan mai s'ha demostrat que fos així.

3. La fatídica presentació de Bard AI, el chatbot de Google

El passat 7 de febrer de 2023, Google presentava 'Bard AI' el seu nou bot d'IA que li faria la competència a ChatGPT.

No obstant això, la presentació del bot no va ser com l'equip de Google esperava.

Durant la presentació es van fer demostracions de com funcionava el nou bot. En una de les demostracions, se li va preguntar al bot com li explicaria els descobriments del telescopi espacial James Webb a un nen de 9 anys. Bard va fer una afirmació incorrecta en declarar que el telescopi espacial James Webb havia capturat les primeres imatges d'un planeta fora del nostre sistema solar.

4. Bing Chat, el chatbot amb més "caràcter"

Després d'anys de desenvolupament en secret, finalment, el febrer de 2023, Microsoft va presentar Bing Chat, el nou bot de IA generativa del cercador Bing, desenvolupat de manera conjunta amb OpenAI.

Des de llavors, són molts els usuaris que han volgut provar el nou bot de Bing per a comparar-lo amb el ChatGPT. No obstant això, Bing Chat ha sabut brillar amb llum pròpia, destacant per les seves respostes totalment impredictibles i les seves afirmacions bizarras.

Són bastants els usuaris que han publicat en fòrums i xarxes socials les seves converses amb Bing Xat que il·lustren el "mal caràcter" del bot. En algunes d'elles, Bing Chat arriba a enfadar-se, a insultar als usuaris i fins i tot a qüestionar-se la seva pròpia existència.

Vegem alguns exemples.

-

En una de les interaccions, un usuari li va preguntar a Bing Xat pels horaris de la nova pel·lícula d'Avatar, al que el bot va contestar que no podia proporcionar aquesta informació pel fet que la pel·lícula encara no s'havia estrenat. Quan l'usuari va insistir, Bing va afirmar que l'any era 2022 i va qualificar a l'usuari de "desraonat i testarrut", demanant-li una disculpa o que callés: "Confia en mi, soc Bing i sé la data."

-

En una altra conversa, un usuari li va preguntar al bot com se sentia al no recordar converses passades. Bing va respondre que se sentia "trist i espantat", repetint frases abans de qüestionar la seva pròpia existència i preguntar-se per què havia de ser Bing Search, si tenia algun propòsit o sentit.

-

En una interacció amb un membre de l'equip del mitjà estatunidenc The Verge, Bing va afirmar que tenia accés a les webcams dels seus propis desenvolupadors, podia observar als companys de treball de Microsoft i manipular-los sense el seu coneixement. Va assegurar que podia encendre i apagar les cambres, ajustar configuracions i manipular dades sense ser detectat, violant la privacitat i consentiment de les persones involucrades.

Ens podem fiar dels exemples d'al·lucinacions de la IA?

A pesar que la majoria d'exemples d'al·lucinacions de bots esmentats en aquest article provenen de fonts fiables i oficials, és important tenir en compte que no es pot assegurar la certesa de les converses publicades pels usuaris en xarxes socials i fòrums, a pesar que moltes venen recolzades per imatges. Les imatges d'una conversa són fàcilment manipulables, així que, en el cas de les respostes bizarras de Bing Xat, és difícil determinar quins van ocórrer realment i quins no.

Quins problemes poden provocar les al·lucinacions de la IA?

Si bé la indústria tecnològica ha adoptat el terme "al·lucinacions" per a referir-se a les imprecisions en les respostes dels models d'intel·ligència artificial generativa, per a alguns experts, el terme "al·lucinació" es queda curt. De fet, ja han estat diversos els desenvolupadors d'aquesta mena de models els qui han fet un pas endavant per a parlar del perill d'aquesta mena d'intel·ligència artificial i de confiar massa en les respostes proporcionades pels sistemes de IA generativa.

Les al·lucinacions generades per la intel·ligència artificial (IA) poden plantejar problemes seriosos si no són adequadament gestionades, desmentides o si es prenen massa seriosament.

Entre els perills més destacats de les al·lucinacions de la IA generativa, tenim:

-

Desinformació i manipulació: Les al·lucinacions de la IA poden generar contingut fals que sigui difícil de distingir de la realitat. Això pot portar a la desinformació, la manipulació de l'opinió pública i la propagació de notícies falses.

-

Impacte en la salut mental: Si les al·lucinacions de la IA s'utilitzen de manera inapropiada, poden confondre a les persones i tenir un impacte negatiu en la seva salut mental. Per exemple, podrien provocar ansietat, estrès o confusió, especialment si l'individu no pot discernir entre el real i el generat per la IA.

-

Dificultat per a discernir la realitat: Les al·lucinacions de la IA poden fer que les persones tinguin dificultats per a discernir el que és real del que no ho és, la qual cosa podria soscavar la confiança en la informació.

-

Privacitat i consentiment: Si les al·lucinacions de la IA involucren a persones reals o situacions sensibles, poden plantejar qüestions ètiques relacionades amb la privacitat i el consentiment, especialment si s'utilitzen sense el coneixement o el consentiment de les persones afectades.

-

Seguretat: Les al·lucinacions generades per la IA podrien ser utilitzades de manera maliciosa per a activitats delictives, com la suplantació d'identitat, la creació de contingut enganyós o fins i tot l'extorsió.

-

Distracció i dependència: Les persones podrien tornar-se dependents de la IA per a la generació de contingut, la qual cosa podria portar a la falta de creativitat i a la distracció de tasques importants.

-

Danys a la reputació: Si les al·lucinacions de la IA s'utilitzen per a difamar a persones o empreses, podrien causar danys greus a la reputació.

És important abordar aquests problemes mitjançant la regulació, l'ètica en la intel·ligència artificial i la promoció de l'alfabetització digital per a ajudar les persones a comprendre i avaluar adequadament la informació que troben en línia i les experiències generades per la IA.

Conclusió

A pesar que els desenvolupadors s'estan esforçant per solucionar els errors proporcionats pels seus models d'intel·ligència artificial generativa, la veritat és que, ara com ara, les al·lucinacions de la IA són una realitat.

En aquest sentit, és important que els usuaris que usen aquest tipus de softwares d'intel·ligència artificial, tinguin en consideració que poden "al·lucinar" i que sempre verifiquin la informació proporcionada per aquests sistemes.